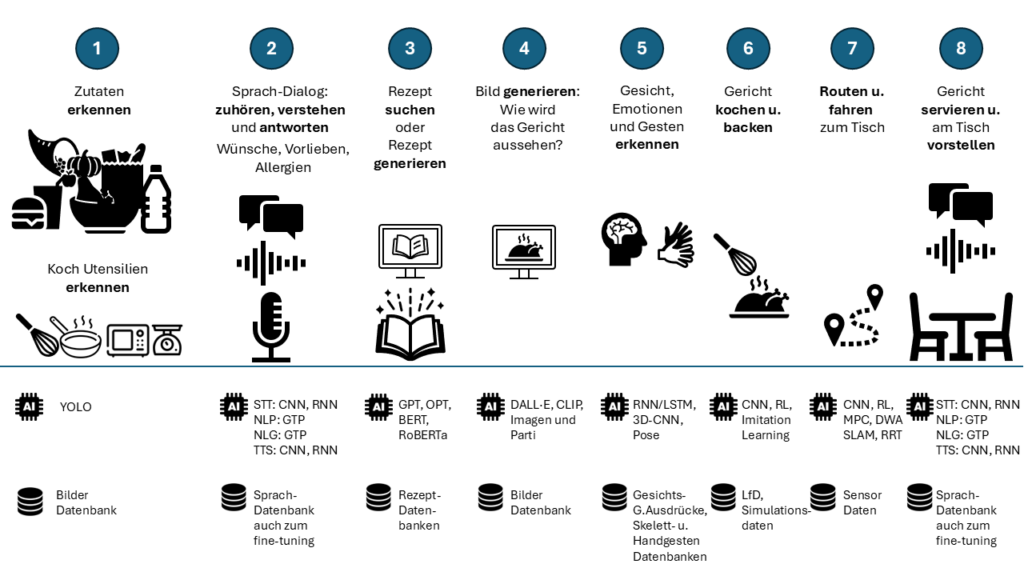

Im Projekt CulinAIBot können für die einzelnen Prozessabschnitte des Workflows – vom Benennen des Wunschgerichts bis zum Servieren – verschiedene KI-Methoden eingesetzt werden. Die notwendigen KI-Methoden für die jeweiligen Schritte habe ich im untenstehenden Bild aufgeführt.

Für die Abgabe beim BWKI habe ich mich auf die Daten, die KI-Methoden und die Implementierung der ersten drei Schritte konzentriert. An den Schritten vier bis acht arbeite ich derzeit weiter.

Bild: Roadmap des CulinAIBot Workflow

Die folgenden Abschnitte beschreiben die Hardware, die Software, die Daten und die KI-Modelle welche ich für CulinAIBot genutzt habe.

Der Abschnitt 2.1 Architektur beschreibt die Gesamtstruktur des CulinAIBot, sowohl auf Hardware- als auch auf Softwareebene. Es wird erläutert, wie die einzelnen Komponenten (wie Roboterarme, Sensorik, Bildverarbeitung, mobile Einheit, KI-Module) integriert sind, um eine reibungslose Interaktion zu ermöglichen.

Der Abschnitt 2.2 Sprach-Dialogsystem wird das Sprachdialogsystem des CulinAIBot beschrieben. Er umfasst die Technologien für die Spracherkennung, das Verstehen natürlicher Sprache (Natural Language Understanding) und ![]() in Zukunft die Sprachsynthese im Hinblick auf die Generierung von Rezepten. Dies werde ich in Zukunft im Hinblick auf die Echtzeit Interaktion zwischen Nutzer und CulinAIBot ausbauen.

in Zukunft die Sprachsynthese im Hinblick auf die Generierung von Rezepten. Dies werde ich in Zukunft im Hinblick auf die Echtzeit Interaktion zwischen Nutzer und CulinAIBot ausbauen.

Der Abschnitt 2.3 Bild- und Objekterkennung erläutert die visuelle Wahrnehmung des CulinAIBot. Der Schwerpunkt liegt auf den Methoden zur Erkennung und Klassifikation von Objekten in der Küchen-Umgebung des CulinAIBot.

Der Abschnitt 2.4 Multimodales Dialogmanagement befasst sich mit der Kombination von Sprache und visuellen Daten zur Verbesserung der Interaktionsfähigkeit des CulinAIBot. D.h. es wird erläutert, wie der CulinAIBot Sprache und Bildinformationen gleichzeitig verarbeitet, um präzisere und kontextbezogene Entscheidungen trifft.

Der Abschnitt 2.5 Action Management beschreibt ![]() in Zukunft die Entscheidungsprozesse und Aktionsausführung des CulinAIBot basierend auf den Eingaben der Nutzer und der Sensoren. Hier werden die Steuerungssysteme erläutert, die die Befehle in physische Handlungen umsetzen, wie etwa das Greifen von Objekten oder die Ausführung von Bewegungsabläufen. Auch die Priorisierung von Aufgaben, die Handhabung konkurrierender Befehle sowie die zeitliche Abstimmung der Aktionen werden in diesem Abschnitt erklärt.

in Zukunft die Entscheidungsprozesse und Aktionsausführung des CulinAIBot basierend auf den Eingaben der Nutzer und der Sensoren. Hier werden die Steuerungssysteme erläutert, die die Befehle in physische Handlungen umsetzen, wie etwa das Greifen von Objekten oder die Ausführung von Bewegungsabläufen. Auch die Priorisierung von Aufgaben, die Handhabung konkurrierender Befehle sowie die zeitliche Abstimmung der Aktionen werden in diesem Abschnitt erklärt.

Der Abschnitt 2.6 Präzisionsmanipulation und Steuerung der Roboterarme beschreibt ![]() in Zukunft die Hardware und Steuerungsmechanismen der Roboterarme des CulinAIBot. Hierbei wird erläutert, wie die Roboterarme für Aufgaben wie präzises Greifen, Manipulieren von Objekten und Interaktion mit der Umgebung eingesetzt werden. Es werden die Mechanik, Sensorik, sowie die eingesetzten Algorithmen zur Bewegungsplanung und -steuerung behandelt. Zusätzlich wird auf Sicherheitsmechanismen eingegangen, die die Interaktion mit dem Nutzer ermöglichen.

in Zukunft die Hardware und Steuerungsmechanismen der Roboterarme des CulinAIBot. Hierbei wird erläutert, wie die Roboterarme für Aufgaben wie präzises Greifen, Manipulieren von Objekten und Interaktion mit der Umgebung eingesetzt werden. Es werden die Mechanik, Sensorik, sowie die eingesetzten Algorithmen zur Bewegungsplanung und -steuerung behandelt. Zusätzlich wird auf Sicherheitsmechanismen eingegangen, die die Interaktion mit dem Nutzer ermöglichen.

Der Abschnitt 2.7 Autonome Navigation und Mobilitätssystem wird ![]() in Zukunft die mobile Einheit des CulinAIBot beschrieben, insbesondere die Hardware und Software der autonomen fahrerlosen Plattform (AGV), die den CulinAIBot mobil macht. Dargestellt werden die verwendeten Sensoren und Algorithmen zur Kartenerstellung, Lokalisierung und Navigation in dynamischen Umgebungen. Darüber hinaus wird die Integration von Hinderniserkennung und -vermeidung, Routenplanung und die Kommunikation zwischen der mobilen Einheit und der Zentral-Einheit des CulinAIBot erläutert.

in Zukunft die mobile Einheit des CulinAIBot beschrieben, insbesondere die Hardware und Software der autonomen fahrerlosen Plattform (AGV), die den CulinAIBot mobil macht. Dargestellt werden die verwendeten Sensoren und Algorithmen zur Kartenerstellung, Lokalisierung und Navigation in dynamischen Umgebungen. Darüber hinaus wird die Integration von Hinderniserkennung und -vermeidung, Routenplanung und die Kommunikation zwischen der mobilen Einheit und der Zentral-Einheit des CulinAIBot erläutert.